在Meta宣布釋出全新大型語言模型Llama 3的同時,相關產業領域的合作夥伴也紛紛宣布支援Llama 3,其中作為Meta自行持有的超級電腦的技術供應商的NVIDIA當然也在第一時間宣布消息;NVIDIA強調採用NVIDIA技術所建構的Meta Llama 3獲得NVIDIA GPU加速挹注,能夠自雲端與資料中心至邊際與個人電腦的NVIDIA GPU以最佳化的方式進行推論,且自即日起即可使用。

NVIDIA同步於ai.nvidia.com提供開發者以NVIDIA NIM微服務嘗試Llama 3:ai.nvidia.com

▲Meta工程師在24,576個NVIDIA H100 GPU叢集完成Llama 3模型訓練

NVIDIA進一步揭露Meta的訓練方式,表示Meta工程師透過以NVIDIA Quantum-2 Infiniband連接的24,576個NVIDIA H100 Tensor GPU的大型叢集進行Llama 3模型訓練,同時NVIDIA也協助Meta對Llama 3的網路、軟體與模型架構進行微調。

此外針對開發者,將可自瀏覽器嘗試於nvidia.ai.com透過NVDIA NIM嘗試Llama 3,透過標準應用程式介面能在任何地方進行部署;企業則可透過隸屬NVIDIA Enterprise一環的NVIDIA NeMo以自身持有的資料將Llama 3進行微調,並透過NVIDIA Tensor-RT-LL進行推論最佳化,最後透過NVIDIA Triton推論伺服器進行部署。

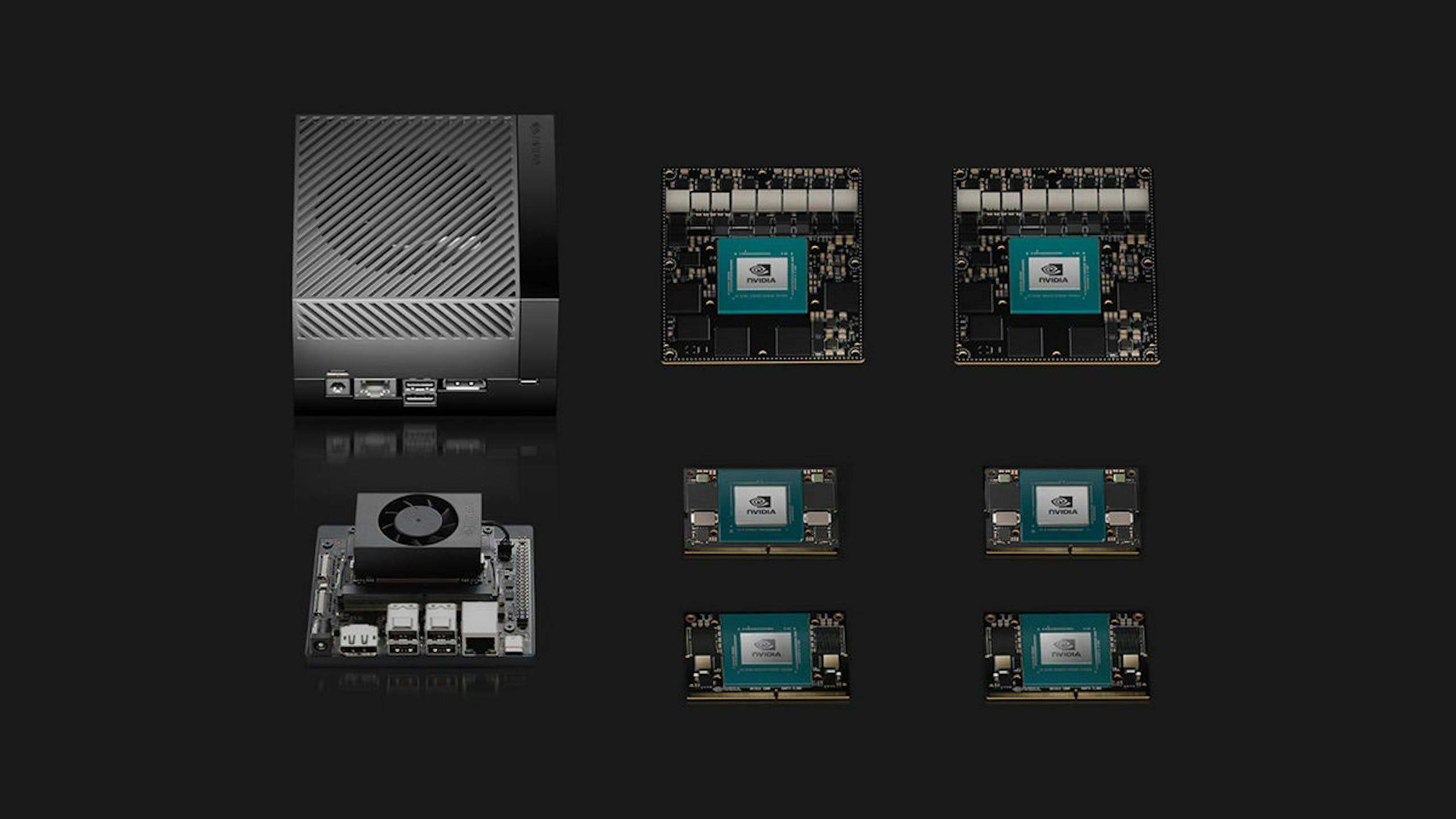

▲Jetson AGX Orin每秒可產生40個詞元、Jetson Nano能產生15個詞元

透過NVIDIA H200 Tensor Core GPU執行Llama 270B參數模型推論時,每秒可產生約3,000個詞元(Token),足以負荷300個使用者同時使用,若採用具備8個H200 GPU的NVIDIA HGX系統,則最多可支援2,400個使用者;同時受惠於架構的一致性,Llama 2能在各式的NVIDIA GPU進行部署與獲得最佳化推論效果,不光僅限於搭載NVIDIA RTX、NVIDIA GeForce RTX的個人電腦與工作站,甚至也能在NVIDIA Jetson Orin的機器人與邊際運算設備執行,在使用8B參數的Llama 3時,Jetson AGX Orin每秒可達40個詞元、低功耗的Jetson Orin Nano則可產生15個詞元。